一、Ollama Windows安装

Ollama 是一个专注于本地运行大型语言模型(LLM)的框架,它使得用户能够在自己的计算机上轻松地部署和使用大型语言模型,而无需依赖昂贵的GPU资源。Ollama 提供了一系列的工具和服务,旨在简化大型语言模型的安装、配置和使用过程,让更多人能够体验到人工智能的强大能力。

1、下载地址:Ollama

2、下载完成后,双击OllamaSetup.exe,一路无脑点击,Ollama很快就安装好了。

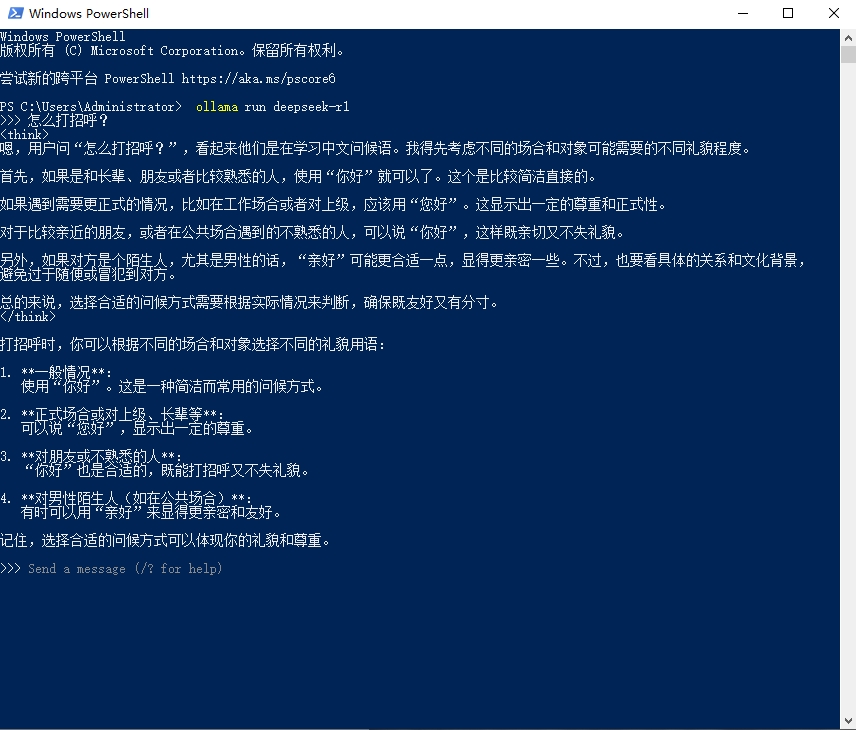

3、安装后打开Windows PowerShell,直接就可以运行ollama安装模型了,例如:

ollama run deepseek-r1

安装其他模型可在Ollama官网查找:Ollama Models

4、模型安装完成后,就可以在Windows PowerShell中使用了:

虽然已经可以用模型的功能了,但是这种指令交互的方式还是不太方便,因此需要搭建支持UI交互的功能,可以考虑PageAssist(Chrome插件)、Open WebUI、AnythingLLM等,本文主要介绍AnythingLLM的方式。

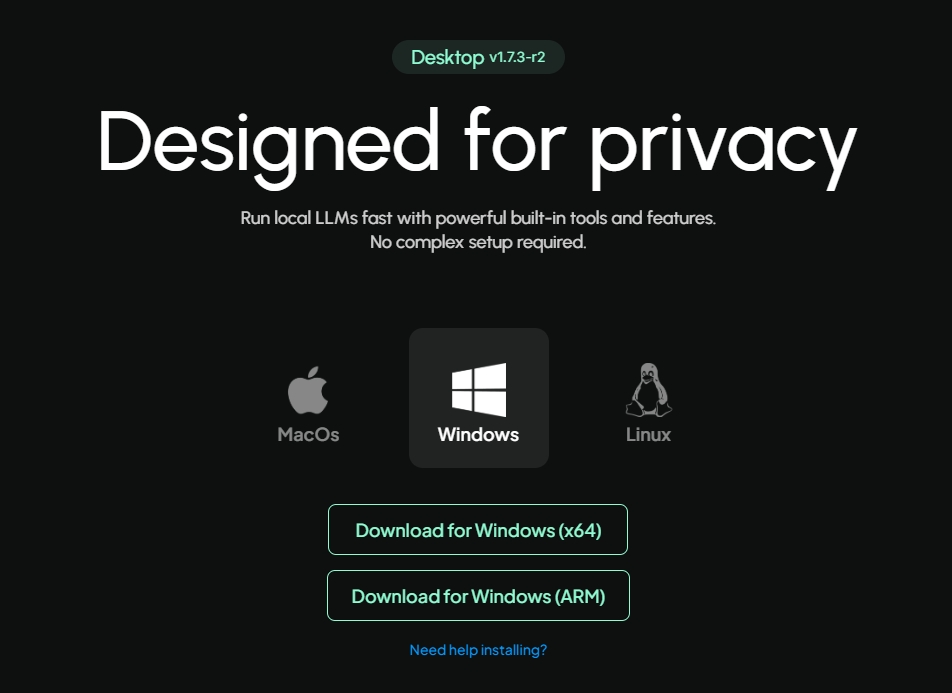

二、直接安装AnythingLLM桌面客户端

访问官网下载Windows桌面客户端安装即可。

下载地址:AnythingLLM | The all-in-one AI application for everyone

三、使用Dock+AnythingLLM安装

1、下载Dock:Get Started | Docker

2、安装完成后在 cmd 里执行以下命令拉取 Anythingllm 的镜像:

docker pull mintplexlabs/anythingllm3、然后在 PowerShell 里执行:

$env:STORAGE_LOCATION="$HOME\Documents\anythingllm"; `

If(!(Test-Path $env:STORAGE_LOCATION)) {New-Item $env:STORAGE_LOCATION -ItemType Directory}; `

If(!(Test-Path "$env:STORAGE_LOCATION\.env")) {New-Item "$env:STORAGE_LOCATION\.env" -ItemType File}; `

docker run -d -p 3001:3001 `

--cap-add SYS_ADMIN `

-v "$env:STORAGE_LOCATION`:/app/server/storage" `

-v "$env:STORAGE_LOCATION\.env:/app/server/.env" `

-e STORAGE_DIR="/app/server/storage" `

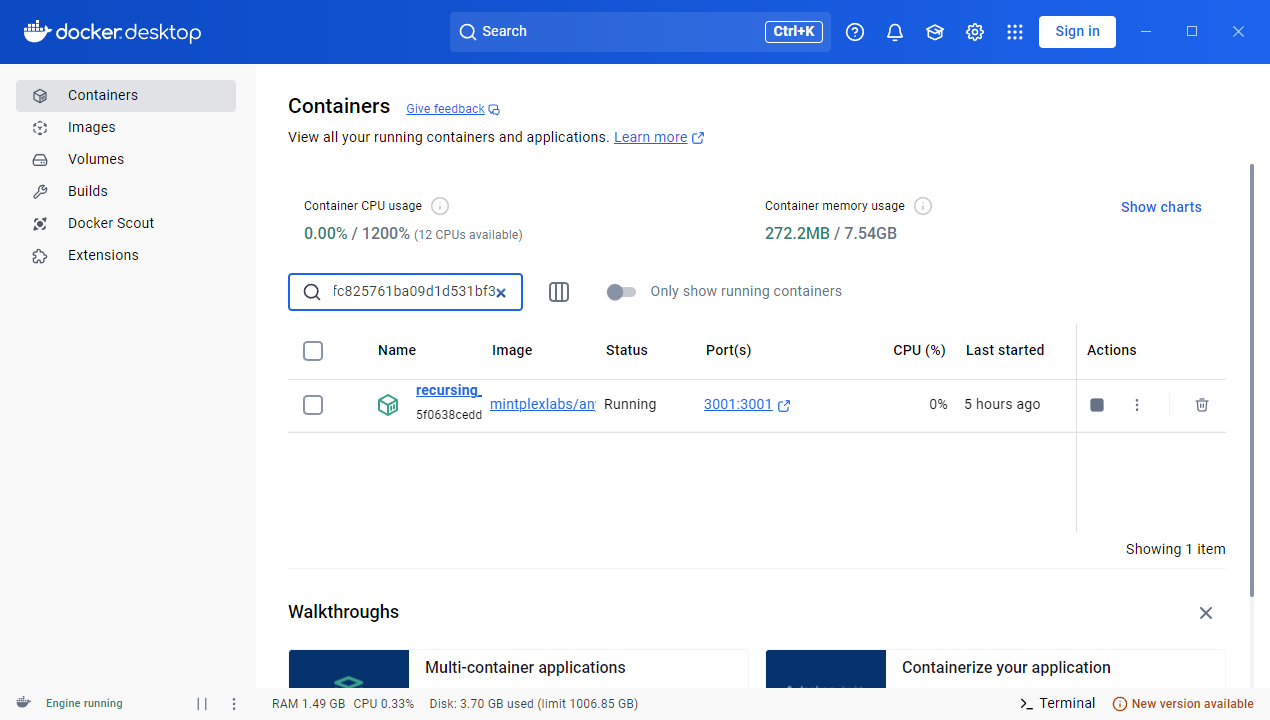

mintplexlabs/anythingllm;4、上述执行完成后,可进行访问。如下如所示:

点击端口3001即可跳转到对应界面:

现在就可以开始使用了,局域网其他用户也可以访问http://{ip}:3001来使用。

更新:

前期使用时,发现只使用了CPU,GPU基本没动,据说是需要下载CUDA。

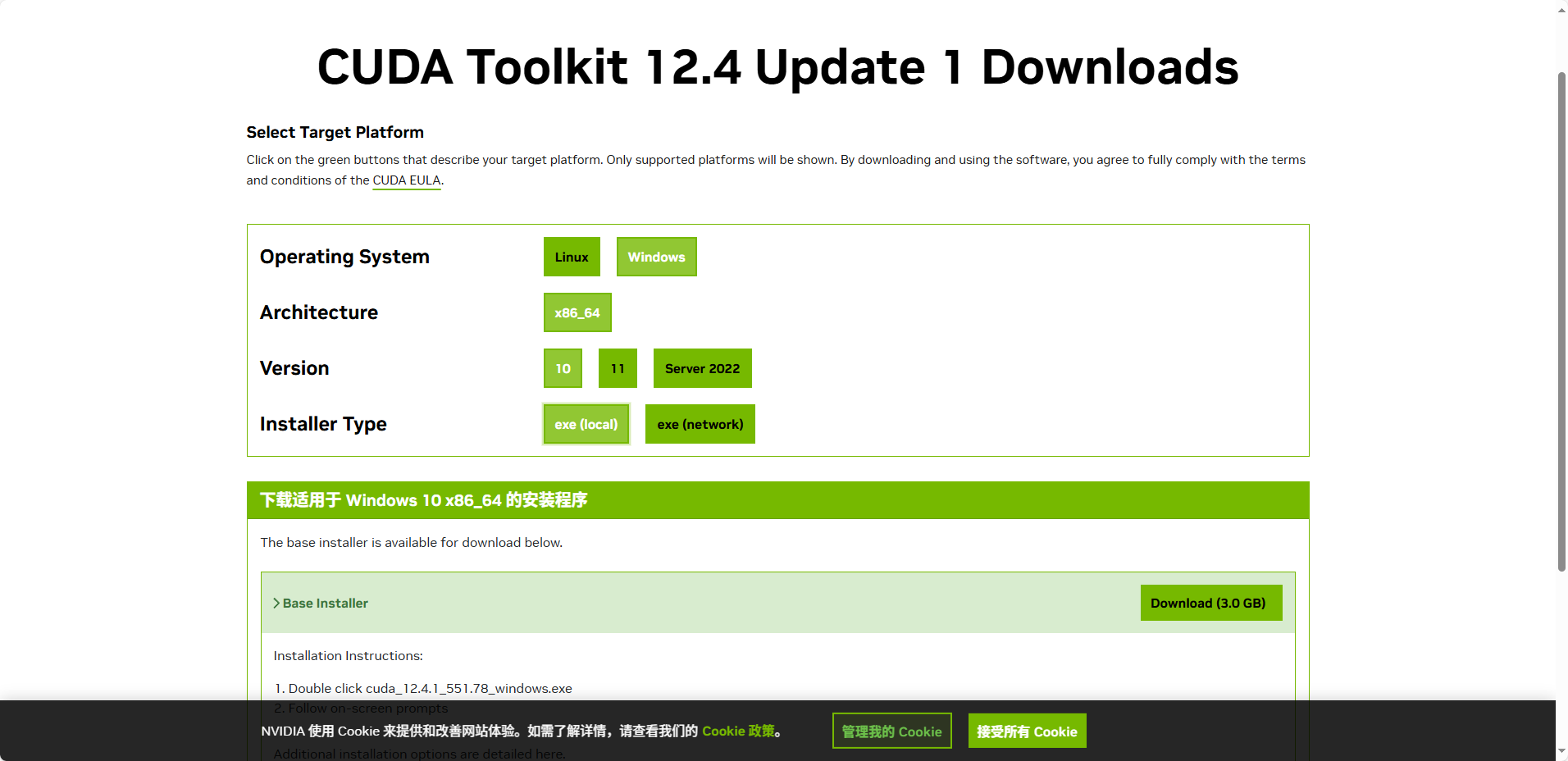

1、安装CUDA

安装CUDA前,需要先部署Python环境:

- Python:推荐 Python 3.8 或以上版本

- 下载地址:Welcome to Python.org

CUDA下载地址:CUDA Toolkit 12.4 Update 1 Downloads | NVIDIA 开发者

下载和安装CUDA的过程会比较慢,需要耐心等待。安装完成后,重启计算机。

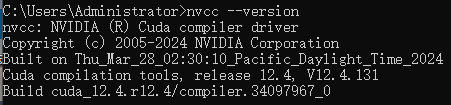

2、通过使用命令提示符检查是否已安装CUDA

首先,打开命令提示符。你可以按 Win + R 键,输入 cmd,然后按回车键。在命令提示符中输入以下命令并按回车:

nvcc --version如果已安装CUDA,你将看到类似以下的输出:

3、配置环境变量(很重要)

安装完成后,需要配置环境变量以确保系统能够找到CUDA工具。在Windows搜索栏中输入“环境变量”,选择“编辑系统环境变量”,然后点击“环境变量”。

在“系统变量”部分,找到并编辑Path变量,添加以下路径(根据实际安装路径调整):

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.x\bin

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.x\libnvvp这里的v12.x对应不同的版本,根据目录可以具体查看。本机安装的版本为v12.4。